MIT tədqiqatçıları kontekst pəncərəsi məhdudiyyətini aşan RLM yanaşmasını təqdim etdi

MIT CSAIL RLM yanaşmasını təqdim etdi: mətn REPL-də dəyişən kimi saxlanır, model isə seçmə sorğularla 10 milyon tokendən çoxu işləyir.

MIT tədqiqatçıları kontekst pəncərəsi məhdudiyyətini aşan RLM yanaşmasını təqdim etdi

«startuphub.ai» məlumatına görə, MIT-nin Kompüter Elmləri və Süni Zəka Laboratoriyasının (CSAIL) tədqiqatçıları Recursive Language Models (RLM) adlı ümumi inferensiya strategiyasını təqdim edib.

Yanaşma böyük dil modellərinin “kontekst pəncərəsi” məhdudiyyətini yan keçərək effektiv giriş uzunluğunu 10 milyon tokendən çox miqyaslandıra bilir.

Son Xəbərlər

Xiaomi 15 Ultra Qlobal Versiyası

Xiaomi yeni flaqman modeli Xiaomi 15 Ultra-nı qlobal satışa çıxaracağını təsdiqlədi. HyperOS 2.0 ilə yeni dövr başlayır!

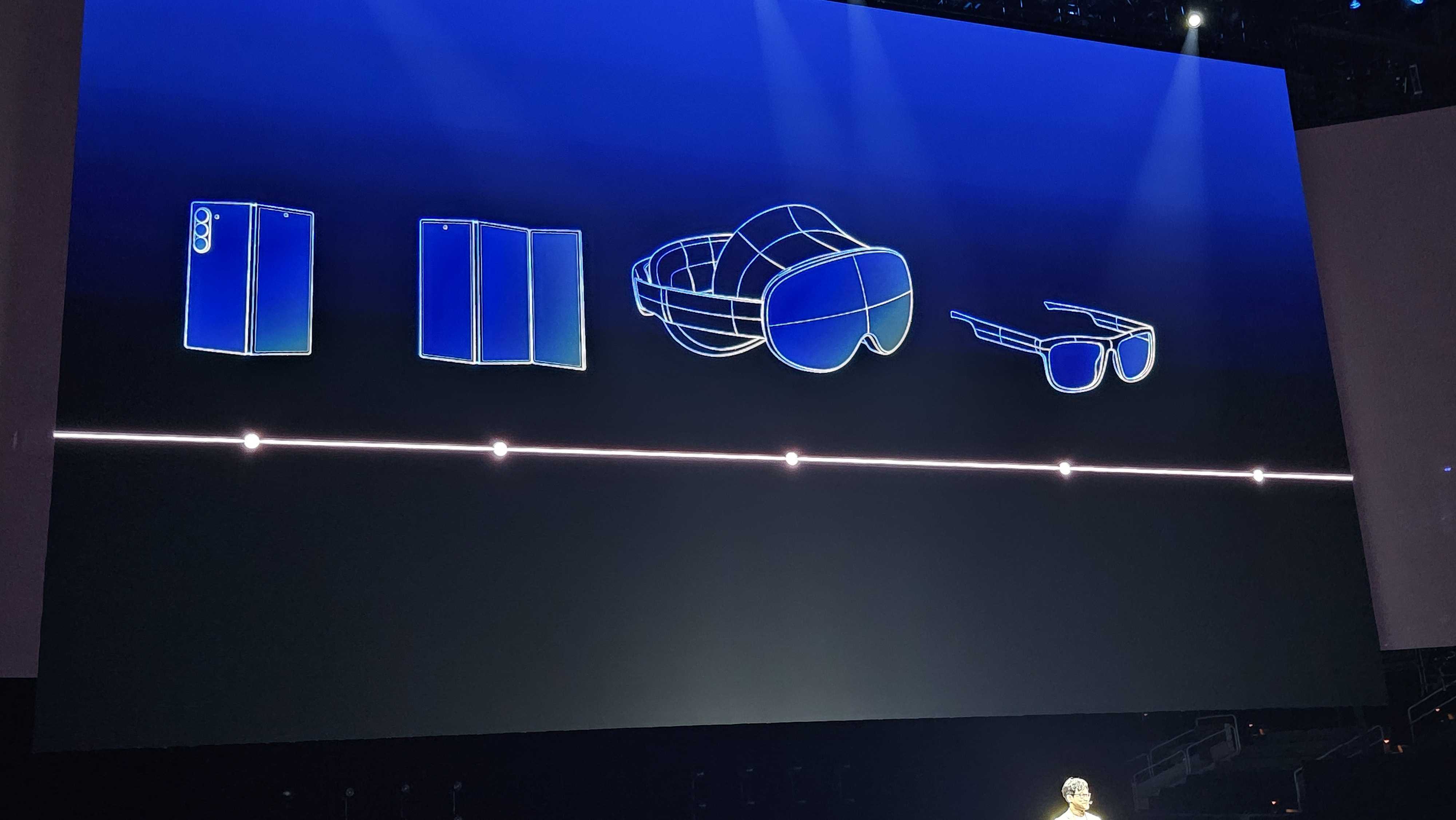

Samsung-un Üçqatlanan Telefonu

Samsung, Galaxy Unpacked tədbirində üçqatlanan telefon konseptini təqdim etdi. Yeniliklər haqqında daha çox məlumat əldə edin.

Realme GT 7: Ən Ucuz Smartfon

Snapdragon 8 Elite çipi ilə Realme GT 7 fevral ayında təqdim ediləcək. Yeni xüsusiyyətlər və uyğun qiymət gözləyir.

Məqalədə uzun mətnlərdə keyfiyyətin tez düşməsi kimi təsvir olunan “kontekst çürüməsi” problemi hədəflənir. Qeyd edilir ki, həddi keçəndən sonra mətni təkrar xülasələşdirməyə söykənən üsullar məlumat itkisi yaradır və çoxaddımlı məntiq tapşırıqlarında uğursuzluğa aparır.

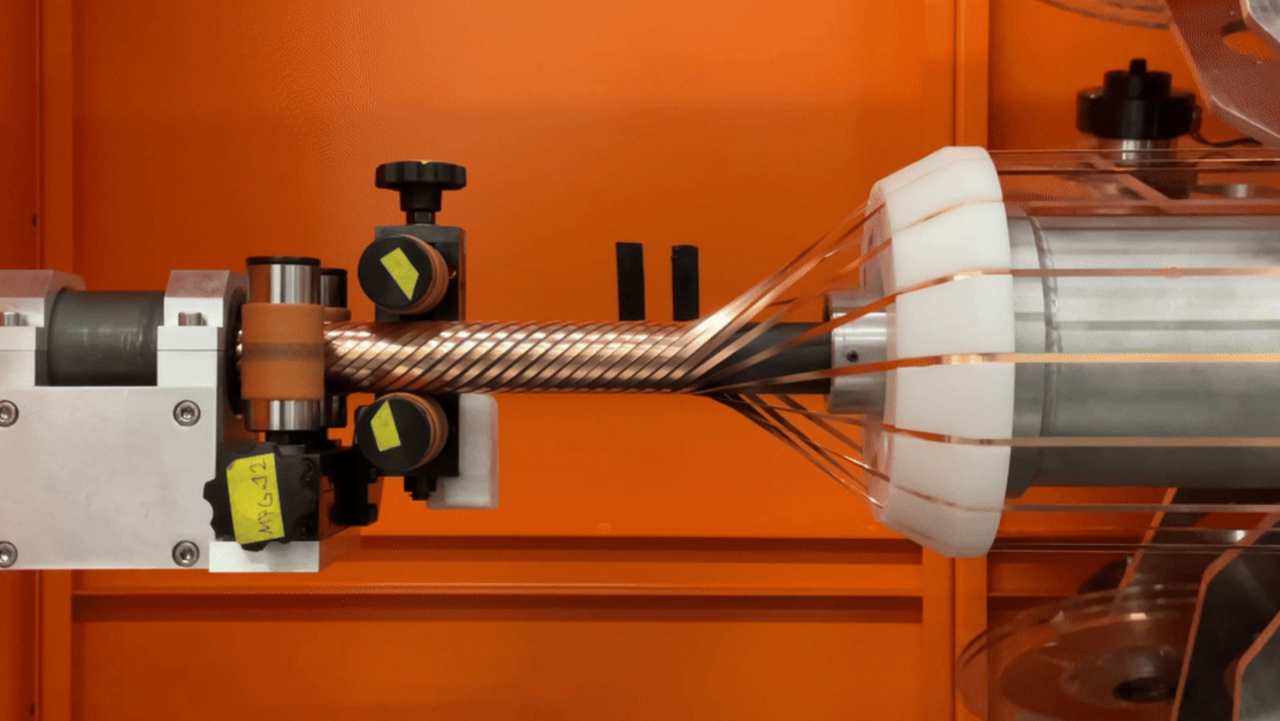

RLM-də uzun mətn birbaşa modelə “yüklənmir”, Python Read-Eval-Print Loop (REPL) mühitində dəyişən kimi saxlanır. Model isə kod yazıb icra etməklə həmin dəyişəndən yalnız lazım olan hissələri seçərək sorğulayır və rekursiv şəkildə özünü çağıraraq yekun nəticəni qurur.

Dörd tapşırıq üzrə qiymətləndirmədə - dərin araşdırma, məlumatların toplanması, kod repozitoriyasının anlaşılması (CodeQA) və sintetik cüt-müqayisə (OOLONG) - RLM-lərin 10 milyon+ token miqyasında da güclü nəticə verdiyi bildirilir. BrowseComp+ (1 min sənəd) tapşırığında GPT-5 ilə işləyən RLM-in 91,33 faiz dəqiqlik göstərdiyi qeyd olunur.

Materialda həmçinin xərclərdən bəhs edilir: RLM-lərin seçmə baxış hesabına 3 dəfəyədək daha ucuz ola bildiyi, çünki modelin hər cavabda bütün ardıcıllığı emal etmədiyi vurğulanır. Yanaşmanın modeldən asılı olmadığı və həm qapalı (GPT-5), həm də açıq mənbə (Qwen3-Coder) modellərə tətbiq oluna biləcəyi qeyd olunur.

Bu xəbəri necə dəyərləndirirsiniz?