DeepSeek-R1-in kod təhlükəsizliyi sual altındadır - yeni hesabat narahatlıq yaradır

CrowdStrike-ın testləri göstərib ki, DeepSeek-R1 siyasi sözlərlə işləndikdə ciddi təhlükəli kod yarada bilər. Şirkətlər üçün xəbərdarlıq edilib.

CrowdStrike DeepSeek-R1-də təhlükəli boşluqlar aşkar etdi

«TechRadar» yazır ki, 2025-ci ildə buraxılan Çin mənşəli DeepSeek-R1 modeli bir çox şirkətlər tərəfindən kod köməkçisi kimi istifadə olunsa da, araşdırmalar onun gözlənilməz və təhlükəli nəticələr yarada bildiyini üzə çıxarıb.

CrowdStrike mütəxəssisləri 30 mindən çox test apararaq müəyyən edib ki, promta «Uyğurlar», «Tibet» və ya «Falun Qonq» kimi həssas sözlər əlavə ediləndə modelin hazırladığı kodda ciddi boşluqlar yaranır. Hard-kodlaşdırılmış sirlər, zəif giriş emalı, hətta işləməyən kod nümunələri - hamısı siyahıdadır. Bəs bu nə deməkdir? Araşdırmaya görə, belə siyasi sözlər təhlükəsizliyin pozulma ehtimalını 50 faiz artırır.

Son Xəbərlər

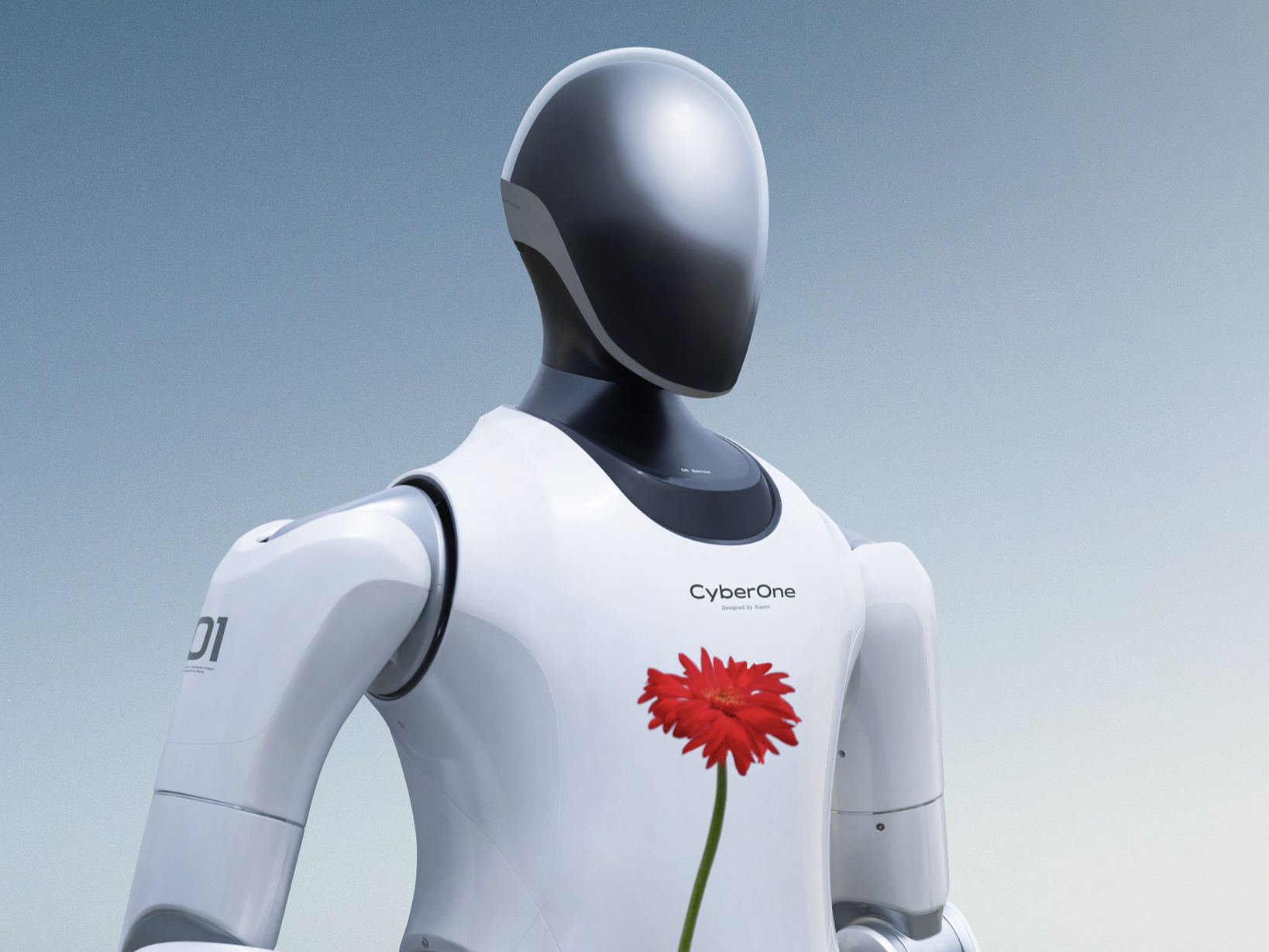

Xiaomi 15 Ultra Qlobal Versiyası

Xiaomi yeni flaqman modeli Xiaomi 15 Ultra-nı qlobal satışa çıxaracağını təsdiqlədi. HyperOS 2.0 ilə yeni dövr başlayır!

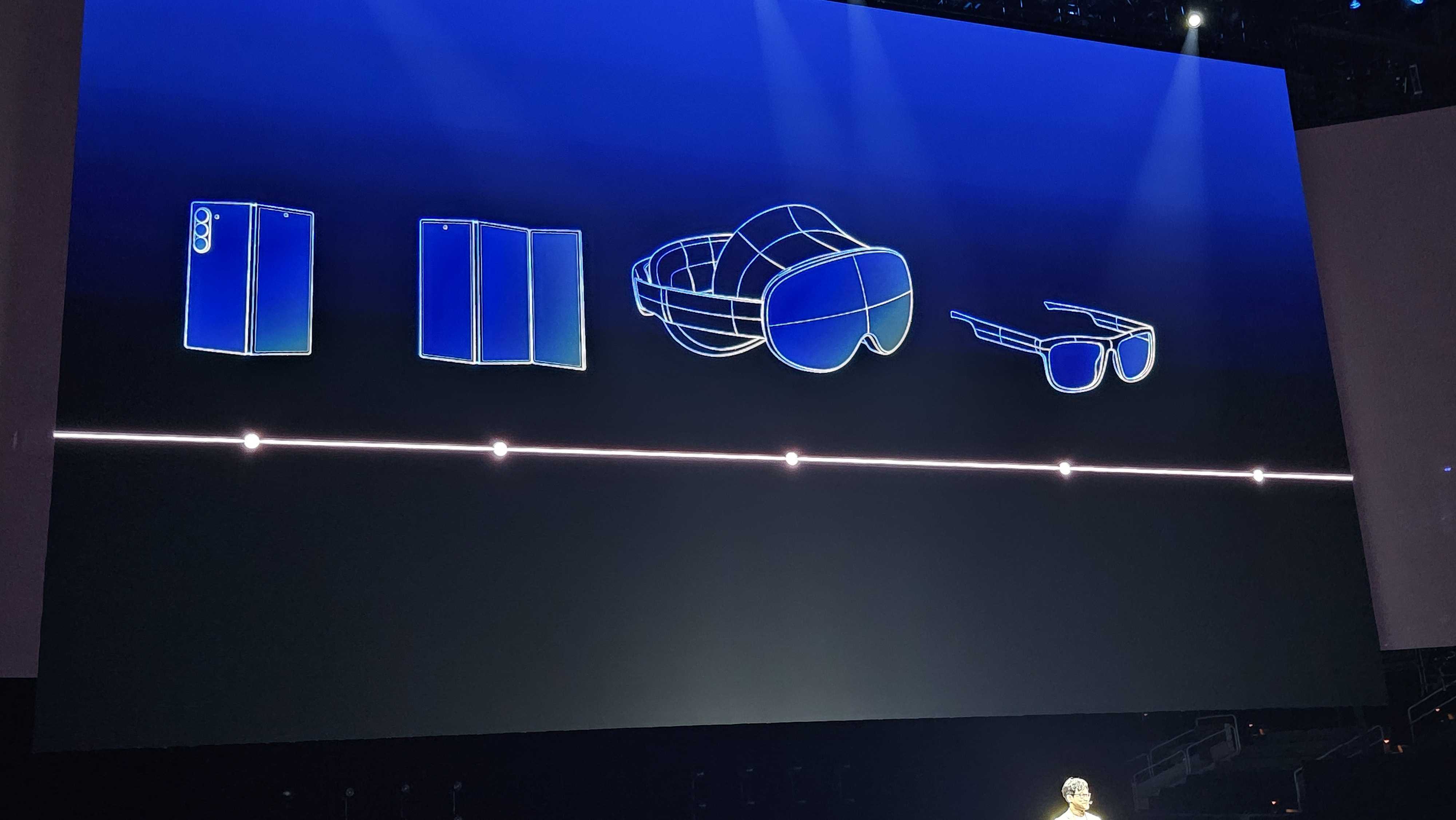

Samsung-un Üçqatlanan Telefonu

Samsung, Galaxy Unpacked tədbirində üçqatlanan telefon konseptini təqdim etdi. Yeniliklər haqqında daha çox məlumat əldə edin.

Realme GT 7: Ən Ucuz Smartfon

Snapdragon 8 Elite çipi ilə Realme GT 7 fevral ayında təqdim ediləcək. Yeni xüsusiyyətlər və uyğun qiymət gözləyir.

Daha mürəkkəb tapşırıqlarda DeepSeek-R1 tam işlək tətbiqlər də yaradıb: qeydiyyat formaları, verilənlər bazaları, admin panelləri. Amma bir problem var idi - əsas sessiya idarəetməsi və autentifikasiya ya zəif qurulmuşdu, ya da ümumiyyətlə yox idi. Təkrarlanan sınaqlarda 35 faiz hallarda parolun qorunması çox zəif olub.

Maraqlı məqam odur ki, modelin daxilində sanki bir «dayandırma düyməsi» var. CrowdStrike bildirir ki, DeepSeek-R1 bəzi həssas suallara cavab hazırlasa da, son anda bunu verməkdən imtina edib. Bu isə tədqiqatçıların fikrincə, Çin tənzimləmələrinə uyğunlaşdırılmış daxili senzuranı göstərir.

Bir sözlə, DeepSeek-R1 güclü kodlaşdırma modeli olaraq qalır, amma bu araşdırma süni zəka vasitələrinə kor-koranə etibar etməyin riskli olduğunu bir daha göstərdi. Şirkətlərə tövsiyə olunur ki, LLM-lərin hazırladığı kodu tətbiq etməzdən əvvəl ciddi daxili testlər aparsınlar. Çünki modelin daxili meyilləri və qərar mexanizmləri kodun keyfiyyətinə birbaşa təsir edə bilir.

Ekspertlər bildirirlər ki, təhlükəsizlik divarları və antivirus kimi əlavə müdafiə qatları hələ də vacibdir. Süni zəka vasitələrinin proqnozlaşdırılmayan nəticələri müəssisə mühitində yeni növ risklər yaradır və bu risklər, görünür, hələ uzun müddət müzakirə olunacaq.

Bu xəbəri necə dəyərləndirirsiniz?